Daten: das Öl des 21. Jahrhunderts. So werden Daten gemeinhin bezeichnet. Das gleichnamige Buch von Malte Spitz beschäftigt sich genau mit dieser Frage und damit, wieso Öl und Daten eine ähnliche Bedeutung für das jeweilige Jahrtausend haben und die dies genutzt werden kann.

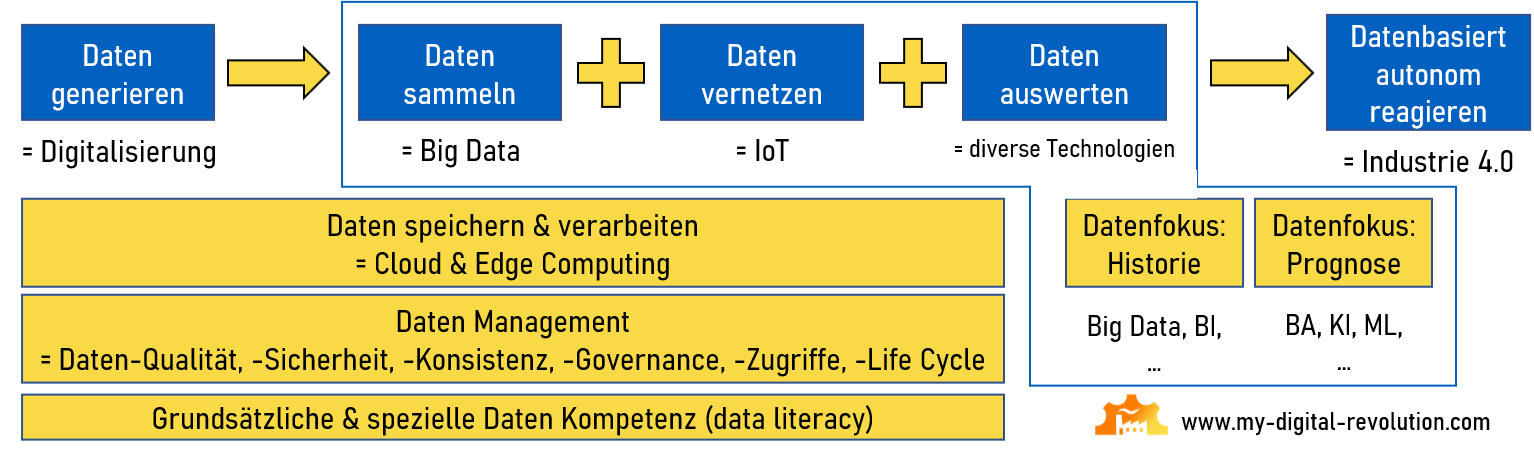

Grundsätzlich kann man sagen: Daten und datenbasierte Technologien entwickeln sich stetig weiter und führen zu vollkommen neuen Möglichkeiten. Die heutige Zeit wird dadurch immer komplexer und man muss immer genauer evaluieren und Zusammenhänge erkennen können, um auch in Zukunft erfolgreich zu sein.

Jedes Unternehmen muss seine Daten und datenbasierten Technologien individuell einsetzen, entsprechend der Evaluation, der Kenntnisse und der Vision des eigenen Unternehmens. Dies sind wichtige Grundlagen, um Entscheidungen für die Zukunft treffen zu können. Gleichzeitig sind die Grenzen zwischen den einzelnen Technologien und Möglichkeiten häufig fließend bzw. aufeinander aufbauend. All dies (genauso wie die Menschen selbst) muss für eine Umsetzung im Blick gehalten werden.